L'IA non è neutrale, è di parte come gli esseri umani

Tutto il chiacchierare che ruota attorno all'intelligenza artificiale è spesso polarizzante: spesso si esagerano i suoi aspetti positivi e le sue capacità o si sottolineano gli aspetti negativi temendo l'arrivo di Skynet. Non dovremmo però lasciare che i veri problemi che circondano l'AI si perdano in questo mare di sensazionalismo. Un problema comune che stiamo già osservando è che l'AI è tutt'altro che neutrale. Può discriminare e discrimina perché spesso eredita pregiudizi umani.

Il fascino dell'intelligenza artificiale è comprensibile. È in grado di analizzare grandi quantità di dati senza soluzione di continuità e di fare previsioni basate solo su fatti concreti e freddi. O almeno così ci piace pensare. La verità è, tuttavia, che la maggior parte dei dati di formazione che gli algoritmi di apprendimento automatico utilizzano oggi sono costruiti dagli esseri umani o almeno con il coinvolgimento umano. E poiché la maggior parte degli algoritmi attuali non sono open source, non possiamo sapere quanto siano complete le informazioni ricevute da una AI e se tutte le variabili sono state tenute in considerazione.

Problemi esistenti e futuri

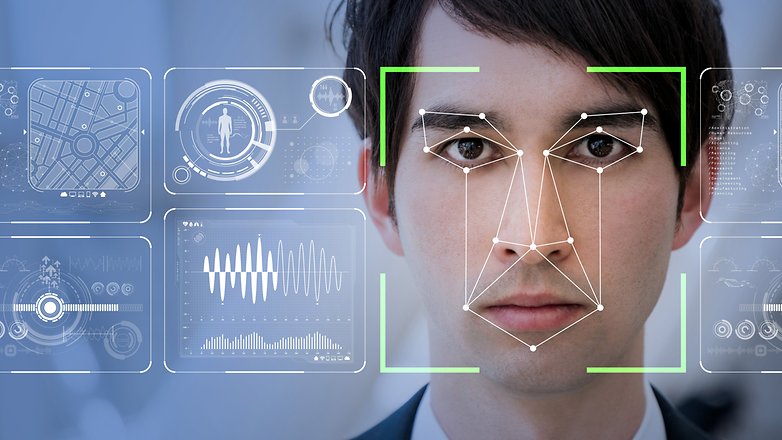

Perché questo è un problema? L'intelligenza artificiale non si limita a curare le raccomandazioni di Netflix o i feed dei social media, sta prendendo sempre più spesso decisioni che possono avere un impatto significativo sulla vostra vita. Gli algoritmi di machine learning vengono utilizzati per analizzare i curricula e selezionare i candidati idonei, per prevedere i tassi di recidiva e alcuni stanno addirittura cercando di individuare futuri terroristi in base alle loro caratteristiche facciali.

Ci sono già stati casi che dimostrano come l'AI possa ereditare i pregiudizi umani e emarginare ulteriormente le minoranze o i gruppi vulnerabili. Uno degli esempi più noti è uno strumento di assunzione sperimentale di Amazon che discriminava le donne. L'algoritmo valutava i candidati da una a cinque stelle e doveva selezionare quelli più adatti al lavoro. Tuttavia ha iniziato a discriminare le donne perché i dati con cui è stata istruita l'AI provenivano tutti da CV di candidati maschi. Ha pertanto raggiunto la conclusione che le donne non siano adatte al lavoro e ha penalizzato le applicazioni contenenti la parola "donna". Anche se il programma è stato modificato e reso neutrale, il progetto è stato scartato e non ha mai visto l'effettiva attuazione.

Uno studio di Pro Publica, d'altra parte, ha scoperto che il COMPAS (un algoritmo che dovrebbe prevedere la recidiva) era razzista. La loro analisi ha trovato che "gli imputati neri avevano molta più probabilità degli imputati bianchi di essere giudicati erroneamente come a più alto rischio di recidiva, mentre gli imputati bianchi avevano più probabilità degli imputati neri di essere erroneamente segnalati come a basso rischio".

Casi come questi dimostrano come la trasparenza sia estremamente importante nel campo dell'AI. Quando una macchina prende decisioni sul futuro di una persona, dobbiamo sapere su cosa si basano queste decisioni. Nel caso del COMPAS, si utilizzavano i dati relativi all'incarcerazione. Tuttavia, basarsi su dati storici può avere i suoi problemi: le macchine incontreranno modelli storici colorati per genere, razza e altri pregiudizi. Solo perché, per esempio, storicamente ci possono essere stati meno candidati maschi per le posizioni infermieristiche, ciò non significa che gli uomini siano meno qualificati o meritevoli.

Ci sono anche casi in cui l'intelligenza artificiale può essere giusta, ma per i motivi sbagliati. Secondo il Washington Post, un professore dell'Università di Washington ha condiviso l'esempio di un collega che ha addestrato un sistema informatico per distinguere tra cani e lupi. I test hanno dimostrato che il sistema era accurato quasi al 100%. Ma si è scoperto che il computer ha avuto successo perché ha imparato a cercare la neve sullo sfondo delle foto. Tutte le foto del lupo sono state scattate nella neve, mentre le foto del cane no.

Infine, dobbiamo discutere i casi in cui l'AI viene utilizzata in combinazione con dati e scienze dubbie. Una startup israeliana chiamata Faception afferma di essere in grado di identificare potenziali terroristi in base alle loro caratteristiche facciali con l'aiuto dell'intelligenza artificiale. Più preoccupante, secondo il Washington Post, hanno già firmato un contratto con un'agenzia per la sicurezza del territorio nazionale.

Il CEO dell'azienda, Shai Gilboa, afferma che "la nostra personalità è determinata dal nostro DNA e si riflette nel nostro volto. È una specie di segnale." Faception utilizza 15 classificatori che possono presumibilmente identificare certi tratti con una precisione dell'80%. Tuttavia questi numeri non garantiscono certezza e si potrebbe facilmente cadere nel 20% dei casi in cui si viene erroneamente scambiati per terroristi. La scienza che sta alla base di tutto questo è altamente discutibile. Alexander Todorov, un professore di psicologia di Princeton ha detto al Post che "la prova che ci sia accuratezza in questi giudizi è estremamente debole". L'azienda rifiuta inoltre di rendere pubblici i suoi classificatori. Non è difficile capire come questo possa avere conseguenze disastrose.

Soluzioni potenziali

Un'azienda che sta affrontando apertamente la questione dell'AI è IBM. Ha sviluppato una nuova metodologia per ridurre la discriminazione esistente in un insieme di dati. L'obiettivo è che una persona abbia le stesse possibilità di "ricevere una decisione favorevole", ad esempio per un prestito, indipendentemente dalla sua appartenenza ad un gruppo "protetto" o "non protetto".

Tuttavia, la ricercatrice IBM Francesca Rossi ha anche posto l'accento sui cambiamenti che l'industria stessa deve apportare. Secondo lei, lo sviluppo dell'intelligenza artificiale deve avvenire in ambienti multidisciplinari e con un approccio multiculturale. Crede anche che più impariamo sui pregiudizi dell'AI, più impariamo sui nostri.

Francesca Rossi è anche piuttosto ottimista. Essa afferma che la parzialità dell'AI può essere eliminata entro i prossimi cinque anni. Eppure, non è facile essere d'accordo con lei. Un cambiamento culturale significativo deve avvenire prima nell'industria tecnologica. L'approccio multidisciplinare da lei proposto potrebbe spingere questo cambiamento. È anche estremamente necessario, molti sviluppatori e ricercatori non hanno una formazione in etica o in campi correlati.

Un altro passo verso la soluzione del problema del pregiudizio dell'AI potrebbe essere la sua democratizzazione ovvero rendere gli algoritmi disponibili al pubblico in modo che possano studiarli, capirli e utilizzarli al meglio. Aziende come OpenAI sono già su questa strada. È tuttavia improbabile che coloro che proteggono la loro proprietà intellettuale seguano l'esempio.

Come potete vedere, non c'è una risposta facile. Una cosa è certa: non dovremmo fidarci ciecamente della tecnologia e aspettarci che risolva tutti i nostri problemi. Le AI non sono state create dal nulla, sono un prodotto della società e quindi ereditano tutti i nostri pregiudizi e preconcetti umani.

Quali sono i vostri pensieri sull'argomento? Fateci sapere nei commenti.