108 Megapixel su Xiaomi Mi Note 10: quanto valgono?

Esattamente dieci anni fa Canon ha presentato la sua "Wonder Camera", una concept camera da 100 megapixel per l'era della fotografia computazionale. I giapponesi avevano pianificato di rilasciarla nel 2030. Nel frattempo però abbiamo già raggiunto smartphone capaci di offrire numeri a tre cifre quando si parla di megapixel. Ma cosa significa concretamente? I 108 megapixel di Xiaomi Mi Note 10 sono irrilevanti o folli?

I sensori di immagine si scontrano con un problema di immagine: i megapixel vengono ancora considerati l'indicatore più importante della qualità dell'immagine. Molto più importante è in realtà la dimensione del sensore: più grande è, maggiore è la quantità di luce che cattura. Più luce significa, per dirla in parole povere, meno rumore e capacità di errore durante la lettura e quindi una migliore qualità dell'immagine.

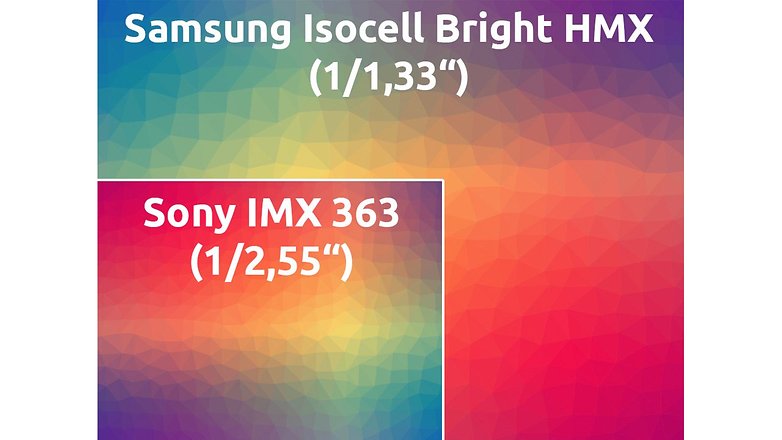

Con il sensore Samsung Isocell Bright HMX installato su Xiaomi Mi Note 10, la dimensione del sensore passa in secondo piano. Purtroppo, perché il chip sensibile alla luce è davvero dannatamente grande con 1/1,3 pollici. Corrisponde ad una superficie di circa 70 millimetri quadrati. Si tratta di uno spazio circa tre volte superiore a quello del sensore IMX 363 di Sony che Google utilizza ad esempio sul Pixel 4 (XL).

Con l'impostazione predefinita, Xiaomi Mi Note 10 scatta foto da 27 megapixel, quindi combina sempre quattro dei piccoli pixel da 0,8 micron in un unico pixel da 1,6 micron. Qualcosa che abbiamo già visto su smartphone con fotocamere da 48 megapixel che scattano foto da 12 megapixel come impostazione predefinita. Il sensore isocell sviluppato congiuntamente da Samsung e Xiaomi prende il nome Tetracell Technology.

Perché non utilizzare un sensore da 27MP?

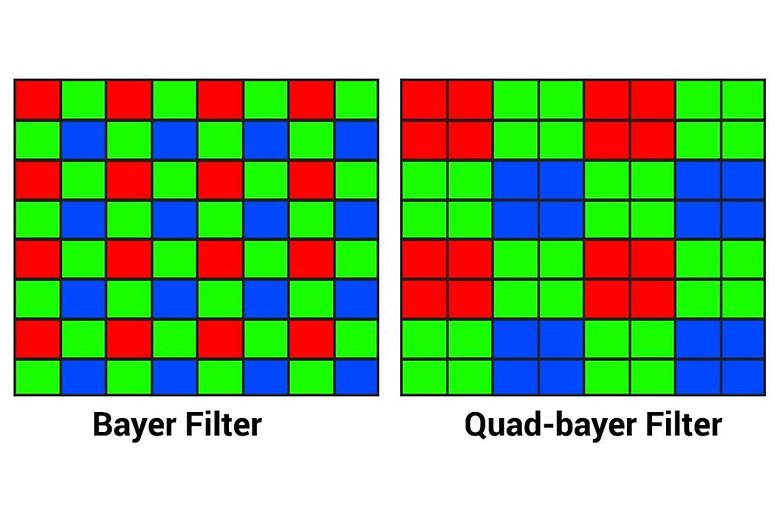

Passare da un'alta ad una bassa risoluzione ha dei vantaggi, almeno sulla carta. Ogni sensore di immagine su smartphone funziona con uno schema Bayer, che suddivide i pixel presenti sul sensore in pixel verdi, rossi e blu secondo il rapporto 2:1:1:1.

Senza questo schema ogni pixel sul chip misurerebbe stupidamente solo la luminosità ed avremmo una fotocamera in bianco e nero. Il software della fotocamera calcola i valori di colore RGB di ogni pixel in base ai pixel circostanti di un colore diverso sul sensore.

Lo schema Bayer sul sensore Tetracell sviluppato da Samsung e Xiaomi, come i cosiddetti sensori Quad-Bayer di Sony con 48 megapixel, non ha 108 megapixel, ma solo 27. Quattro pixel sotto ogni filtro di colore. Il vantaggio è che i valori di luminosità possono essere misurati in modo più granulare. E quando si tratta di percepire la nitidezza dell'immagine, la risoluzione della luminosità gioca un ruolo più importante rispetto alla risoluzione del colore.

Più megapixel aiutano?

Almeno sulla carta, la risoluzione e soprattutto le dimensioni del sensore sono un vantaggio rispetto alla concorrenza. Ma è come il calcio: anche con la migliore squadra si può perdere una partita se il software (l'allenatore?) non fa il suo lavoro. Solo testando il nuovo smartphone di Xiaomi sarà possibile verificare se il software riesce a trarre vantaggio da un hardware di questo tipo. Perché 108 megapixel significano anche un'enorme quantità di dati da padroneggiare: una singola immagine DNG RAW a 14 bit può risultare in 189 megabyte.

La domanda è: la potenza di calcolo dello smartphone è già matura per gestire una simile quantità di dati? Oppure quello di Google è il giusto approccio per il 2019? Non vediamo l'ora di testare la fotocamera del Mi Note 10 per capire se Xiaomi con i suoi 108 megapixel è in anticipo rispetto ai tempi o se si tratta di una mossa troppo audace!